Inventaire des actifs d'IA

Découvrez et cataloguez automatiquement vos modèles d'IA, vos jeux d'entraînement, vos ensembles de données, vos copilotes et vos applications pilotées par l'IA dans les environnements cloud, SaaS et sur site.

Détecter automatiquement les modèles d'IA, les copilotes et les outils tiers utilisés, qu'ils soient approuvés ou non.

Maintenir un inventaire centralisé et constamment mis à jour des systèmes d'IA et des données associées

Suivre où les modèles sont déployés, quelles données ils utilisent et comment ils sont appliqués.

Définir et appliquer l'accès aux données de formation, aux invites, aux résultats et aux modèles en fonction des rôles.

Identifier et limiter les utilisateurs sur-autorisés et l'utilisation de l'IA dans l'ombre

Limiter l'accès de l'IA aux seuls ensembles de données approuvés, conformes et adaptés à l'objectif visé

Appliquer des contrôles de gouvernance depuis l'ingestion des données jusqu'au déploiement et à l'utilisation des modèles

Surveiller les risques spécifiques à l'IA : partialité, fuite de données, violation des politiques et utilisation non autorisée.

Automatiser la conformité avec les cadres mondiaux tels que le NIST AI RMF, l'EU AI Act et l'ISO 42001.

BigID opérationnalise la gestion de la confiance, du risque et de la sécurité de l'IA avec des capacités réelles - et non pas de la poudre aux yeux :

Découvrez et cataloguez automatiquement vos modèles d'IA, vos jeux d'entraînement, vos ensembles de données, vos copilotes et vos applications pilotées par l'IA dans les environnements cloud, SaaS et sur site.

Identifier et classer les données sensibles, réglementées ou critiques qui alimentent les modèles d'IA - garantir une IA responsable dès le départ.

Contrôlez et surveillez qui peut accéder aux modèles, aux ensembles de données d'entraînement et aux pipelines d'IA. Appliquer le principe du moindre privilège et de la confiance zéro dans les environnements d'IA.

Découvrir les activités d'IA non autorisées, les copilotes malhonnêtes et les déploiements de modèles cachés susceptibles d'introduire des risques ou d'enfreindre les politiques.

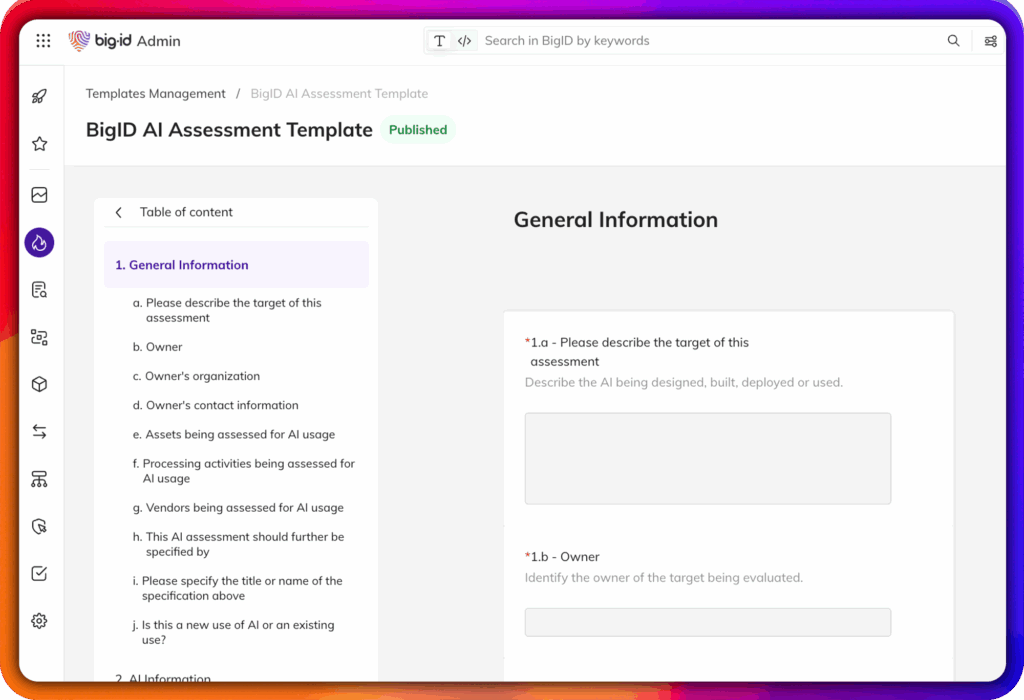

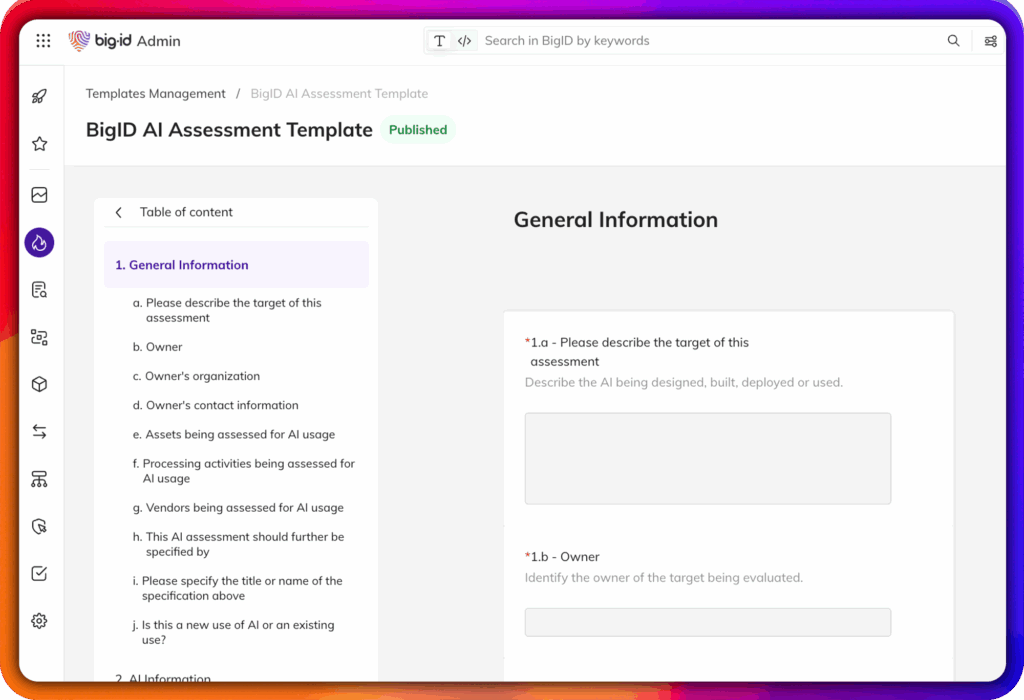

Régir les politiques spécifiques à l'IA en matière de protection de la vie privée, de résidence des données, de sécurité et de conformité réglementaire, y compris les cadres émergents tels que la loi européenne sur l'IA, le RMF de l'IA du NIST et la norme ISO/IEC 42001.

Faites remonter les risques tels que les données de formation surexposées, les accès non sécurisés ou les ensembles de données biaisés, et prenez des mesures pour remédier aux problèmes avant qu'ils ne s'aggravent.

Suivre l'origine, l'évolution et l'utilisation des données et des modèles de formation, afin de soutenir des pratiques d'IA transparentes et explicables pour les audits, la conformité et la gouvernance.

Alerter et prendre des mesures en cas de violations d'accès, de risques liés à l'IA fantôme, de violations de politiques et de menaces émergentes pour vos environnements d'IA.

Favorisez une innovation en matière d'IA fiable, responsable et résiliente grâce à l'AI TRiSM de BigID.